前端技术

HTML

CSS

Javascript

前端框架和UI库

VUE

ReactJS

AngularJS

JQuery

NodeJS

JSON

Element-UI

Bootstrap

Material UI

服务端和客户端

Java

Python

PHP

Golang

Scala

Kotlin

Groovy

Ruby

Lua

.net

c#

c++

后端WEB和工程框架

SpringBoot

SpringCloud

Struts2

MyBatis

Hibernate

Tornado

Beego

Go-Spring

Go Gin

Go Iris

Dubbo

HessianRPC

Maven

Gradle

数据库

MySQL

Oracle

Mongo

中间件与web容器

Redis

MemCache

Etcd

Cassandra

Kafka

RabbitMQ

RocketMQ

ActiveMQ

Nacos

Consul

Tomcat

Nginx

Netty

大数据技术

Hive

Impala

ClickHouse

DorisDB

Greenplum

PostgreSQL

HBase

Kylin

Hadoop

Apache Pig

ZooKeeper

SeaTunnel

Sqoop

Datax

Flink

Spark

Mahout

数据搜索与日志

ElasticSearch

Apache Lucene

Apache Solr

Kibana

Logstash

数据可视化与OLAP

Apache Atlas

Superset

Saiku

Tesseract

系统与容器

Linux

Shell

Docker

Kubernetes

站内搜索

用于搜索本网站内部文章,支持栏目切换。

关于这篇文章,其他用户还搜了这些:

名词解释

作为当前文章的名词解释,仅对当前文章有效。

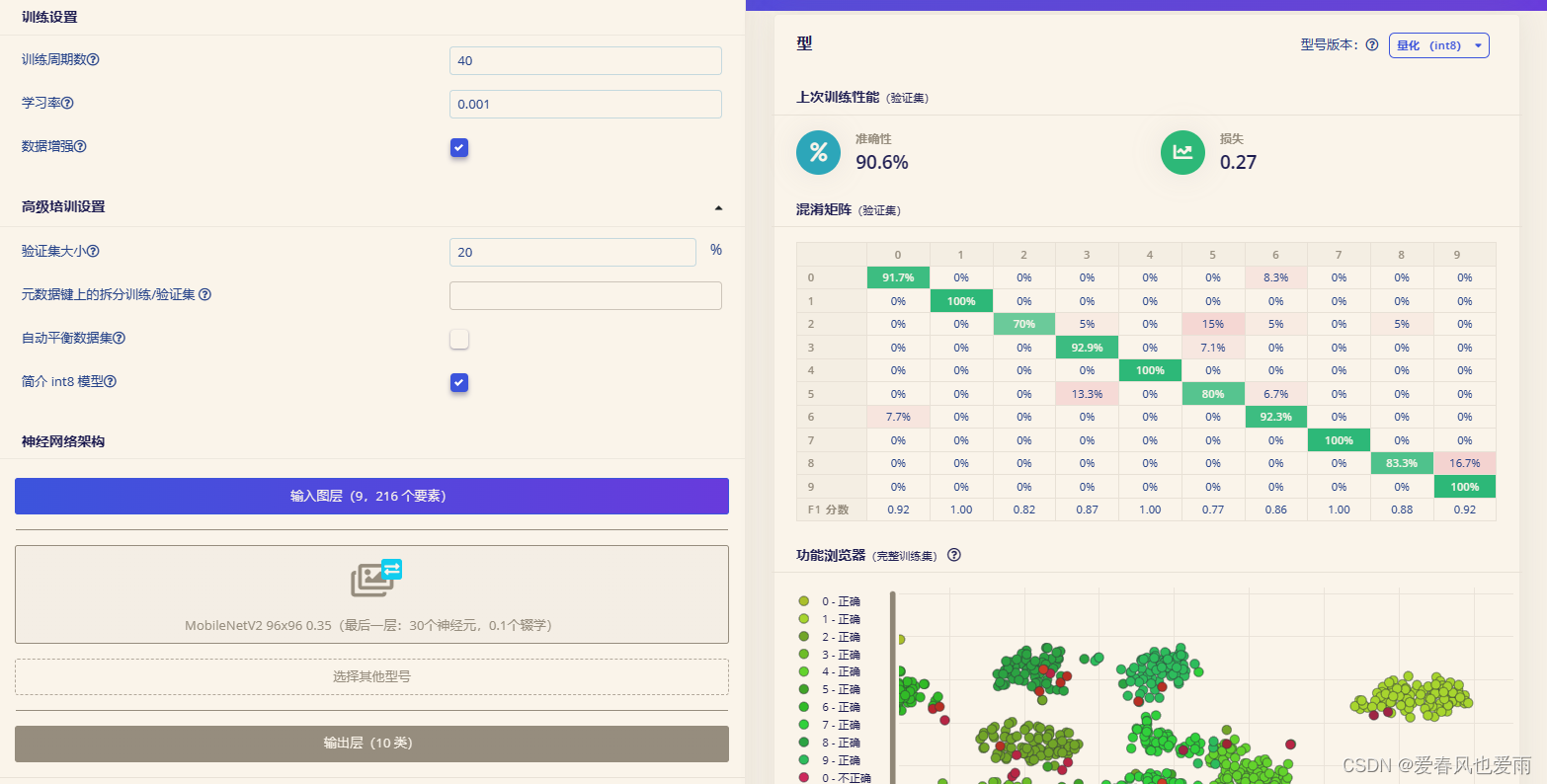

MNIST数据集:MNIST是一个广泛应用于机器学习和计算机视觉领域的手写数字数据库,全称为“Modified National Institute of Standards and Technology”(改进版美国国家标准与技术研究所)手写数字数据集。在本文中,作者使用MNIST数据集来训练模型进行数字识别任务,该数据集包含60,000个训练样本和10,000个测试样本,每个样本都是28x28像素的灰度图像,并且已按照0-9的标签分类。

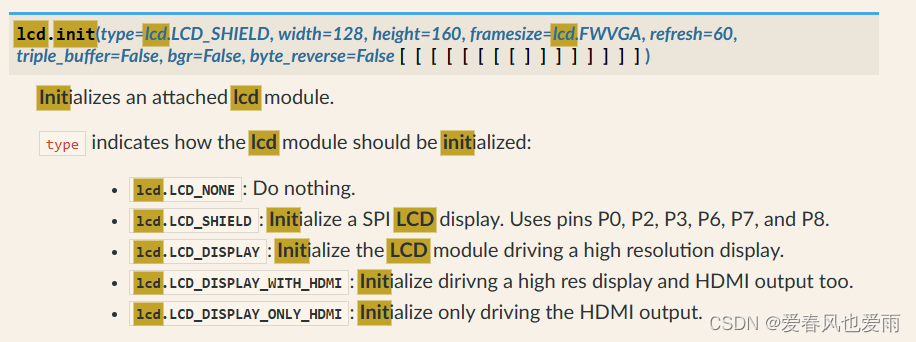

OpenMV:OpenMV是一款专为机器视觉设计的微型控制器开发平台,它集成了高性能的微处理器、摄像头模组以及用于图像处理和机器学习算法的硬件加速器。在文章中,作者通过OpenMV实现了从数字图像采集到模型推理,最终控制直流电机转速的过程,展现了其在嵌入式设备上进行实时目标检测和识别的强大功能。

TensorFlow Lite:TensorFlow Lite是Google推出的轻量级机器学习框架,它是TensorFlow针对移动和嵌入式设备优化的版本。在本项目中,作者将训练好的模型转换为TensorFlow Lite格式,以便在资源有限的OpenMV平台上高效地部署和运行神经网络模型,实现对手写数字的实时识别。

混淆矩阵:混淆矩阵是一种用于评估分类模型性能的统计表,它展示了模型预测结果与实际标签之间的对应关系。在文中,作者通过查看模型训练后的混淆矩阵分析了各个数字类别被正确识别和错误识别的情况,从而找出模型存在的不足并针对性地提出优化建议。

延伸阅读

作为当前文章的延伸阅读,仅对当前文章有效。

随着人工智能和机器学习技术的快速发展,基于OpenMV等微型机器视觉平台实现的手写数字识别应用已不再局限于理论研究,而是越来越多地融入到日常生活中。近日,一款结合了OpenMV与深度学习框架的智能门禁系统成功落地,该系统能够实时识别并验证用户手写的门牌号,大大提升了社区的安全性和便利性,充分展示了MNIST数据集训练模型在实际场景中的高效应用。

此外,针对跨国文化背景下的数字识别差异问题,有研究团队正着手构建包含多元书写风格的全球手写数字数据库,以期通过更全面的数据训练,提升各类设备对手写数字识别的普适性和准确性。同时,也有科研人员积极探索新的图像预处理技术和网络优化算法,如超分辨率技术、注意力机制等,进一步提高识别系统的鲁棒性和精度。

值得注意的是,云端训练与边缘计算的结合正在为OpenMV等嵌入式设备提供强大的后盾支持。例如,阿里云IoT部门最近推出的云端-边缘协同训练方案,允许用户在云端完成大规模数据训练后,将轻量化模型部署至OpenMV等终端设备上,既保证了模型性能,又降低了设备存储和计算压力,对于推动智能硬件在数字识别领域的广泛应用具有深远意义。

总之,在当今AI技术蓬勃发展的大背景下,OpenMV作为微型计算机视觉平台的角色愈发重要,其在手写数字识别项目中的实践不仅体现了技术的先进性,也昭示着未来物联网设备智能化的发展趋势。

此外,针对跨国文化背景下的数字识别差异问题,有研究团队正着手构建包含多元书写风格的全球手写数字数据库,以期通过更全面的数据训练,提升各类设备对手写数字识别的普适性和准确性。同时,也有科研人员积极探索新的图像预处理技术和网络优化算法,如超分辨率技术、注意力机制等,进一步提高识别系统的鲁棒性和精度。

值得注意的是,云端训练与边缘计算的结合正在为OpenMV等嵌入式设备提供强大的后盾支持。例如,阿里云IoT部门最近推出的云端-边缘协同训练方案,允许用户在云端完成大规模数据训练后,将轻量化模型部署至OpenMV等终端设备上,既保证了模型性能,又降低了设备存储和计算压力,对于推动智能硬件在数字识别领域的广泛应用具有深远意义。

总之,在当今AI技术蓬勃发展的大背景下,OpenMV作为微型计算机视觉平台的角色愈发重要,其在手写数字识别项目中的实践不仅体现了技术的先进性,也昭示着未来物联网设备智能化的发展趋势。

知识学习

实践的时候请根据实际情况谨慎操作。

随机学习一条linux命令:

nc host port

- 连接到远程主机的指定端口发送或接收数据。

推荐内容

推荐本栏目内的其它文章,看看还有哪些文章让你感兴趣。

2023-02-18

2023-08-07

2023-09-10

2024-01-12

2023-01-11

2023-10-22

2023-01-13

2023-10-29

2024-01-09

2023-08-26

2023-01-02

2023-05-10

历史内容

快速导航到对应月份的历史文章列表。

随便看看

拉到页底了吧,随便看看还有哪些文章你可能感兴趣。

时光飞逝

"流光容易把人抛,红了樱桃,绿了芭蕉。"

可以看出跟我们的不一样,不过数据集中仍然存在跟常规书写的一样的,我们需要进行人为的筛选。

可以看出跟我们的不一样,不过数据集中仍然存在跟常规书写的一样的,我们需要进行人为的筛选。