前端技术

HTML

CSS

Javascript

前端框架和UI库

VUE

ReactJS

AngularJS

JQuery

NodeJS

JSON

Element-UI

Bootstrap

Material UI

服务端和客户端

Java

Python

PHP

Golang

Scala

Kotlin

Groovy

Ruby

Lua

.net

c#

c++

后端WEB和工程框架

SpringBoot

SpringCloud

Struts2

MyBatis

Hibernate

Tornado

Beego

Go-Spring

Go Gin

Go Iris

Dubbo

HessianRPC

Maven

Gradle

数据库

MySQL

Oracle

Mongo

中间件与web容器

Redis

MemCache

Etcd

Cassandra

Kafka

RabbitMQ

RocketMQ

ActiveMQ

Nacos

Consul

Tomcat

Nginx

Netty

大数据技术

Hive

Impala

ClickHouse

DorisDB

Greenplum

PostgreSQL

HBase

Kylin

Hadoop

Apache Pig

ZooKeeper

SeaTunnel

Sqoop

Datax

Flink

Spark

Mahout

数据搜索与日志

ElasticSearch

Apache Lucene

Apache Solr

Kibana

Logstash

数据可视化与OLAP

Apache Atlas

Superset

Saiku

Tesseract

系统与容器

Linux

Shell

Docker

Kubernetes

站内搜索

用于搜索本网站内部文章,支持栏目切换。

名词解释

作为当前文章的名词解释,仅对当前文章有效。

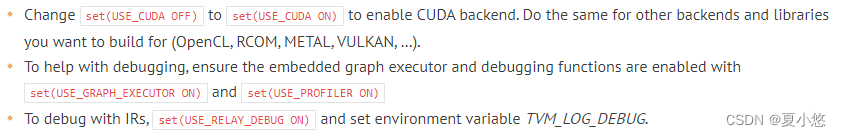

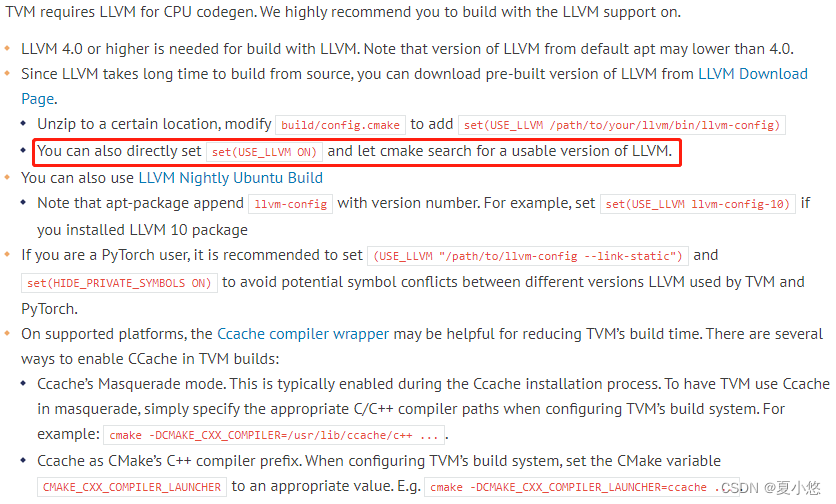

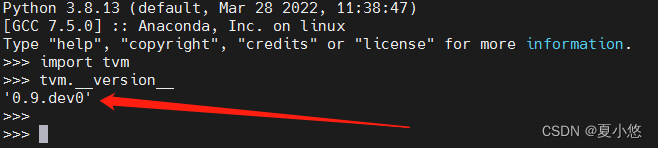

Apache TVM:Apache TVM是一个开源深度学习编译器框架,它提供了一种统一的方式来优化和部署深度学习模型到各种硬件平台,包括CPU、GPU、ASIC和FPGA等。在本文中,作者详细介绍了如何在Linux环境下从源码安装、编译以及验证TVM的正确性,并演示了如何将PyTorch模型转换为可在TVM上运行的形式。

Conda虚拟环境:Conda是一种开源包管理器和环境管理系统,用于在同一个系统上创建和管理多个独立的Python环境。在本文语境中,用户通过Conda创建了一个名为tvmenv的虚拟环境,在其中安装特定版本的Python和其他依赖库,以便于在隔离的环境中编译和使用TVM。

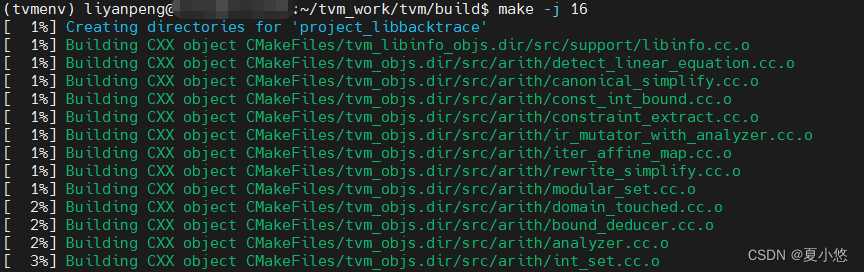

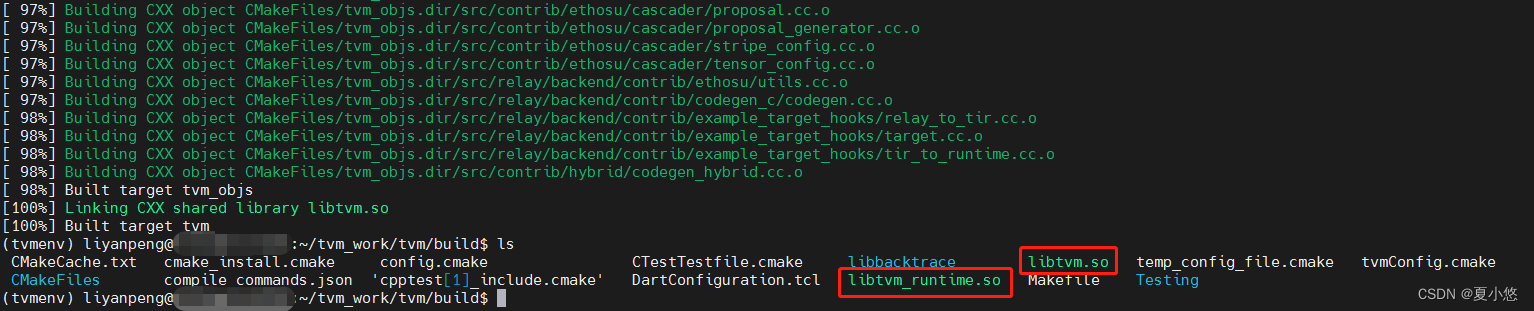

CMake构建系统:CMake是一种跨平台的开源自动化构建系统,用于管理软件项目构建过程中的配置、编译和安装步骤。在本文中,用户在TVM目录下创建build文件夹并使用CMake来配置和编译TVM源代码,生成适用于目标平台(如CPU)的动态链接库libtvm.so和libtvm_runtime.so。

PyTorch模型转换:在深度学习领域,PyTorch模型转换是指将训练或预训练好的PyTorch模型转化为另一种框架或中间表示形式的过程。在本文中,展示了如何利用TVM前端接口将PyTorch模型转换成TVM可识别和执行的Relay IR(中间表示),从而实现在TVM上运行和优化该模型的功能。

Relay IR:Relay IR是Apache TVM中的一个关键组件,它是TVM采用的一种高级中间表达格式,用于表示深度学习模型。通过将不同深度学习框架(例如PyTorch)导出的模型转换为Relay IR,TVM能够进一步对模型进行优化并在不同后端硬件上高效执行。在文章中,用户通过from_pytorch函数将PyTorch模型转化为Relay IR以供后续编译和执行。

延伸阅读

作为当前文章的延伸阅读,仅对当前文章有效。

在成功安装并编译Apache TVM后,开发者可以进一步探索如何利用这一高性能深度学习编译器优化模型,并将其部署至不同硬件平台。近期,TVM社区动态频繁,例如,发布了最新的稳定版1.0,对API进行了大量优化,增强了与更多深度学习框架如TensorFlow、PyTorch以及MXNet的兼容性,并且支持更多的硬件后端,包括GPU、CPU、ASIC和FPGA等。

此外,随着AI技术在边缘计算领域的快速发展,TVM在边缘设备上的应用也越来越受到关注。一项最新研究显示,通过TVM进行模型压缩和量化,能够在保持模型精度的同时,显著减少推理时延,有效提升了诸如自动驾驶、无人机监控等场景中边缘设备的实时处理能力。

对于希望深入了解TVM内部工作原理和技术细节的读者,推荐查阅其官方文档和论文《TVM: An Automated End-to-End Optimizing Compiler for Deep Learning》。该论文详细阐述了TVM的设计理念和关键技术,为开发者提供了理论基础和实践指导。同时,积极参与TVM社区的讨论和贡献,也是提升自己在深度学习编译器领域技能的重要途径。不少开发人员分享了他们在使用TVM过程中优化模型性能、解决实际问题的经验心得,这些内容均可在GitHub项目页面及相关的技术论坛中找到,值得深入研读和参考。

此外,随着AI技术在边缘计算领域的快速发展,TVM在边缘设备上的应用也越来越受到关注。一项最新研究显示,通过TVM进行模型压缩和量化,能够在保持模型精度的同时,显著减少推理时延,有效提升了诸如自动驾驶、无人机监控等场景中边缘设备的实时处理能力。

对于希望深入了解TVM内部工作原理和技术细节的读者,推荐查阅其官方文档和论文《TVM: An Automated End-to-End Optimizing Compiler for Deep Learning》。该论文详细阐述了TVM的设计理念和关键技术,为开发者提供了理论基础和实践指导。同时,积极参与TVM社区的讨论和贡献,也是提升自己在深度学习编译器领域技能的重要途径。不少开发人员分享了他们在使用TVM过程中优化模型性能、解决实际问题的经验心得,这些内容均可在GitHub项目页面及相关的技术论坛中找到,值得深入研读和参考。

知识学习

实践的时候请根据实际情况谨慎操作。

随机学习一条linux命令:

df -h

- 查看磁盘空间使用情况(含挂载点与剩余空间)。

推荐内容

推荐本栏目内的其它文章,看看还有哪些文章让你感兴趣。

2023-02-18

2023-08-07

2023-09-10

2024-01-12

2023-01-11

2023-10-22

2023-01-13

2023-10-29

2024-01-09

2023-08-26

2023-01-02

2023-05-10

历史内容

快速导航到对应月份的历史文章列表。

随便看看

拉到页底了吧,随便看看还有哪些文章你可能感兴趣。

时光飞逝

"流光容易把人抛,红了樱桃,绿了芭蕉。"